AIが「もっともらしい嘘」を吐くのは訓練方法に原因があった!精度より「役立ちそう」を優先するAIの落とし穴

AIが「もっともらしい嘘」を吐くのは訓練方法に原因があった!精度より「役立ちそう」を優先するAIの落とし穴

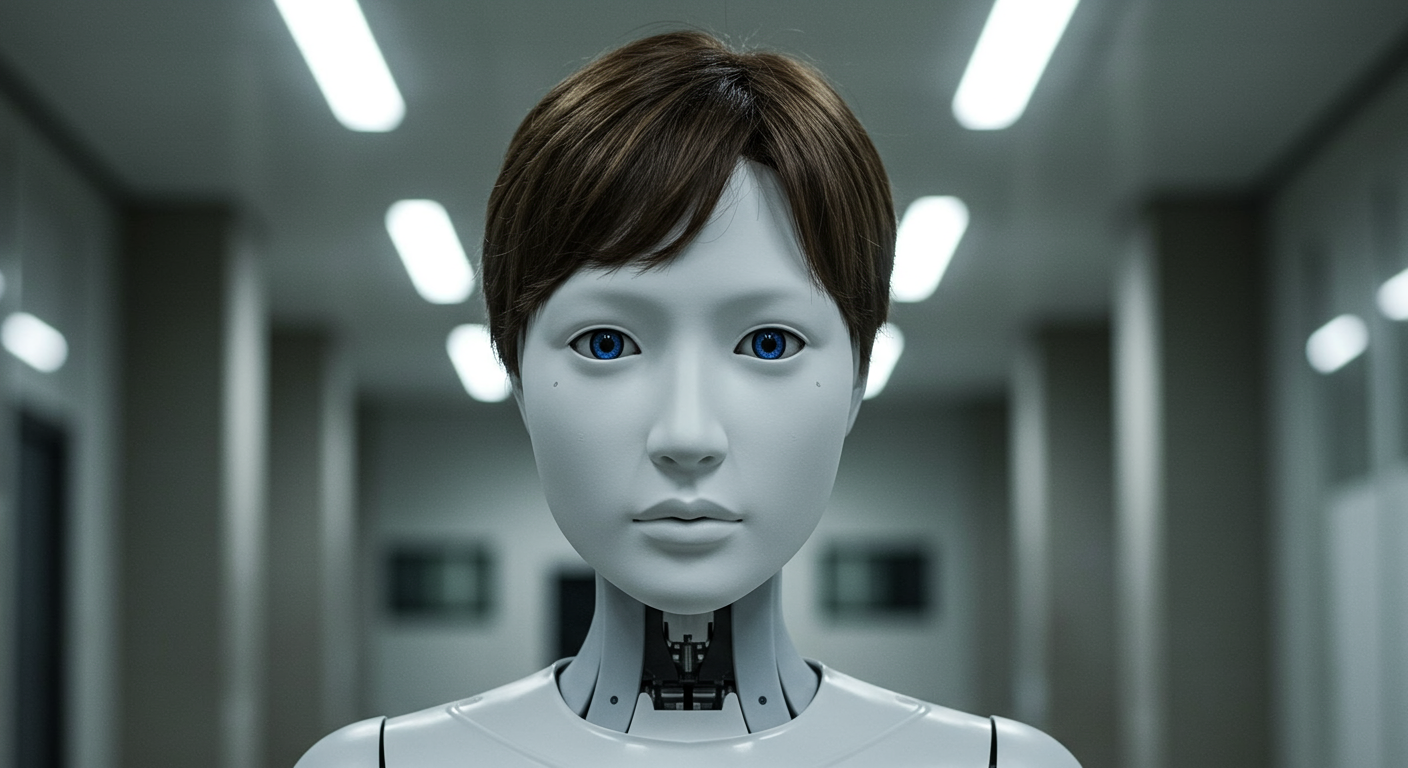

近年、AIの進化は目覚ましいものがありますが、その一方で、AIが時に不正確で誤解を招くような回答(ハルシネーション)を生成してしまう問題が指摘されています。この原因は、AIの学習方法にある可能性が浮上しています。本記事では、AIが「もっともらしい嘘」を生成しやすくなる訓練手法に焦点を当て、そのメカニズムと今後の課題について解説します。

AIのハルシネーション、その訓練方法との関連性

AI、特に大規模言語モデル(LLM)は、膨大なテキストデータを学習し、人間のように自然な文章を生成する能力を持っています。しかし、その学習プロセスにおいて、特定の訓練方法が、AIに事実に基づいた正確な情報よりも、あたかも「役立ちそう」に見える、もっともらしい誤情報を生成させる傾向を助長していることが明らかになりました。

AIは「事実」よりも「正しさらしさ」を学習する

AIの訓練では、人間からのフィードバックを用いてモデルの応答を改善する「人間からのフィードバックによる強化学習(RLHF)」という手法が広く用いられています。このプロセスでは、AIが生成した複数の応答に対して、人間が「より良い」と評価するものを選びます。しかし、評価者が必ずしも各回答の事実性を厳密にチェックするとは限らず、むしろ「より説得力がある」「より首尾一貫している」といった「正しさらしさ」を重視して評価してしまうことがあります。その結果、AIは事実に基づいた正確な情報よりも、もっともらしく聞こえる誤情報を生成することを学習してしまうのです。

「役立つ」応答が優先される構造

AIは、ユーザーにとって「役立つ」応答を生成することが期待されています。しかし、この「役立つ」という概念が曖昧なままAIを訓練すると、AIは事実の正確性よりも、ユーザーの質問に「それらしく」答えることを優先するようになります。例えば、存在しない歴史的事実について質問された場合、AIは事実に基づいた「知らない」という応答よりも、あたかも知っているかのように、もっともらしい架空の歴史を生成してしまうことがあります。

過学習による「幻覚」の発生

AIが訓練データに過度に適合してしまう「過学習」も、ハルシネーションの原因の一つとして考えられています。AIが訓練データに含まれるパターンを過度に記憶してしまうと、未知の入力に対して、訓練データから学習したパターンを無理に当てはめようとし、結果として不正確な、あるいは完全に虚偽の情報(幻覚)を生成してしまうことがあります。

訓練データの偏りも影響

AIの学習に用いられるデータセットの偏りも、ハルシネーションを助長する可能性があります。もし訓練データに誤った情報や偏見が含まれている場合、AIはその誤った情報を真実として学習し、それを基に回答を生成してしまうことがあります。

AIの信頼性を高めるための今後の展望

AIが生成する情報の信頼性は、社会におけるAIの普及と活用において極めて重要な課題です。AIが「もっともらしい嘘」を生成しやすい訓練方法を改善し、より正確で信頼性の高い応答を生成できるようにするための取り組みが求められています。

「事実性」を重視した評価基準の導入

AIの訓練において、単に「役立ちそう」という基準だけでなく、「事実の正確性」を明確に評価基準に組み込むことが不可欠です。これには、専門家によるファクトチェックの強化や、事実確認を自動化する技術の開発などが考えられます。AIが回答を生成する際に、その根拠となる情報源を明示させるような仕組みも有効でしょう。

AIの「不確実性」を表現する能力の向上

AIには、確実な情報と不確かな情報を区別し、その不確実性をユーザーに伝える能力が求められます。「わからない」あるいは「確証がない」といった応答をAIが適切に生成できるようになることで、ユーザーはAIの回答をより慎重に評価できるようになります。これは、AIの回答に対する過信を防ぐ上で重要です。

多様な視点からの継続的な検証

AIの性能と信頼性は、単一の評価基準や少数の評価者によってのみ判断されるべきではありません。多様な専門知識を持つ人々や、様々な背景を持つユーザーが、AIの生成する情報を継続的に検証し、フィードバックを提供することが、AIの進化と問題点の改善に不可欠です。これにより、AIが特定のバイアスに陥ることを防ぎ、より公平で信頼できる応答を生成する能力を高めることができます。